Redacción | Activo$ Bolivia

La inteligencia artificial (IA) está en boca de todos. Desde quienes la usan para simplificar su trabajo hasta los que temen que les quite el empleo, pasando por los que la ven como el futuro inevitable de la humanidad. Pero, detrás del brillo tecnológico, hay riesgos muy reales que no podemos pasar por alto.

Cuando la IA falla y no es tan inteligente

La IA no es infalible. Puede “alucinar” respuestas, inventar datos o exponer información sensible sin que nadie lo note. Y ahí está el gran problema: confiamos en ella como si fuera un oráculo, cuando en realidad depende de los datos que se le alimentan y de sistemas de seguridad que no siempre están blindados.

Imagina que un asistente de IA revela por error información privada de una empresa o que alguien difunde datos falsos generados por un modelo. Lo que parece un detalle menor puede convertirse en un verdadero dolor de cabeza.

OpenAI y las demandas que prenden las alarmas

Un caso que encendió la discusión fue la demanda contra OpenAI. Los críticos cuestionan cómo entrena sus modelos, qué datos utiliza y qué tan transparente es con la privacidad. Más allá del proceso legal, lo que se refleja es una preocupación global sobre la ética y la transparencia en el desarrollo de estas tecnologías. Y aunque es fácil culpar solo a las grandes compañías, lo cierto es que la responsabilidad es compartida: empresas, gobiernos y usuarios tienen algo que aportar.

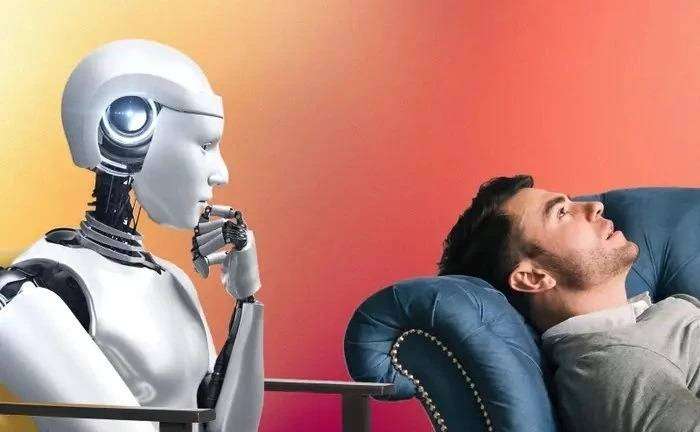

Cuando la IA se usa para lo que no es

Uno de los riesgos más preocupantes es usar la IA como sustituto de terapia. Hay personas que acuden a un chatbot en busca de contención emocional o incluso orientación psicológica. El problema es que, aunque pueda sonar empático, un modelo de IA no es un psicólogo, no tiene la capacidad de diagnosticar ni de acompañar procesos de salud mental. Pretender lo contrario es jugar con fuego.

Aquí la irresponsabilidad no recae en la IA —que no es más que una herramienta—, sino en quienes la usan de manera equivocada. Si un usuario decide reemplazar la ayuda profesional por la respuesta automática de un chatbot, el riesgo es personal y las consecuencias también.

La responsabilidad también es tuya

Sí, las compañías deben garantizar seguridad y transparencia, pero los usuarios no podemos lavarnos las manos. Confiar ciegamente en cualquier respuesta, compartir datos sensibles o sustituir un médico o un terapeuta por una app de IA es como dejar la puerta de tu casa abierta y luego culpar a la cerradura.

La inteligencia artificial es poderosa, pero no mágica. No piensa, procesa. El juicio crítico lo pones tú.

¿Entonces, qué hacemos?

No se trata de apagar la IA ni vivir con paranoia. La clave está en usarla con criterio:

- Verifica la información antes de difundirla.

- No compartas datos sensibles en plataformas que no controlas.

- No uses la IA para lo que no está diseñada (ni es terapia ni reemplazo de un profesional de la salud).

- Recuerda que la responsabilidad del uso siempre recae en el usuario.

La IA puede ser un aliado increíble si aprendemos a convivir con ella de manera consciente. Usada sin criterio, en cambio, puede convertirse en esa caja de Pandora que nadie quiere abrir.